Poche cose hanno raggiunto un grado di isteria collettiva come l’anticipazione del GeForce Gaming Celebration, la conferenza stampa organizzata da Nvidia per svelare le nuove GPU. Eccitazione in parte giustificata dall’assenza di novità di rilievo in quasi 2 anni (dalla presentazione delle GPU Pascal) e dalla quantità spropositata di rumors, speculazioni e fuffa varia girata sul web negli scorsi mesi.

Noi c’eravamo, abbiamo visto, toccato quasi con mano e discusso con gente che ne sa più di noi (ciao Dmitry di Hardware Canucks!). C’è voluto comunque un po’ di tempo per digerire tutte le novità… fate un bel respiro che cominciamo.

Nvidia RTX

La conferenza di Nvidia era decisamente di quelle di alto livello: fuori dalle porte del Palladium di Colonia c’erano circa 1200 persone in attesa di entrare per dare uno sguardo in anteprima al futuro delle GPU del marchio di Santa Clara. Tra le persone in attesa moltissimi gamer che si sono iscritti online e anche parecchi giornalisti, blogger e youtuber hardware d’altissimo profilo. Dopo ore d’attesa, le porte si sono aperte e siamo entrati nella cavernosa sala conferenze. La conferenza, durata quasi 2 ore, è stata densissima di dettagli tecnici. Quasi troppo tecnici, con Jensen Huang (il fondatore e CEO di Nvidia) che si è dilungato ancora e ancora e ancora sul funzionamento delle nuove tecnologie introdotte dalle GPU. “Cose che riflettono cose che riflettono cose che riflettono cose” dovrebbe diventare un meme, siamo seri!

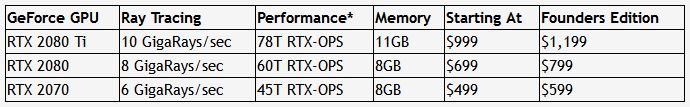

In soldoni, prima di addentrarci nella tecnica, Nvidia ha annunciato tre nuove GPU consumer: RTX 2070, RTX 2080 e RTX 2080 Ti. I tre modelli, che vanno dall’alta all’altissima gamma, si distinguono non solo per quantitativo di RAM (11 GB di GDDR6 per il modello 2080 Ti, 8GB di GDDR5 per i modelli 2070 e 2080) e di prezzo (da 999$ per 2080 Ti, 699$ per la 2080 e un sorprendentemente “a buon mercato” 499$ per il modello 2070 – ma le schede Founders Edition sono più care in tutti e tre gli SKU). In modo molto più aperto di quanto usuale nell’industria, Nvidia ha anche comunicato le performances previste per i tre modelli. E qui cominciano i problemi perché le metriche usate da Nvidia sono due e sono 1) difficilmente calcolabili dagli utenti finali e 2) molto difficili da comparare con altre GPU. Ma ci ritorneremo più avanti, nel paragrafo dedicato al raytracing. Tutte le GPU sono basate sull’architettura Turing, una tecnologia sviluppata per 10 anni dagli ingegneri di Nvidia. I chip, tra i più grandi mai prodotti dall’azienda, includono tre parti distinte: Turing SM, RT Core e Tensor Core. Si tratta di tre sezioni specializzate nel trattamento di diverse funzioni delle GPU RTX tra cui raytracing, NGX Neural Graphic Network e Variable Rate Shading. Termini oscuri che tenteremo di spiegarvi.

L’era del raytracing

Iniziamo con lo spiegare, a sommi capi, cos’è il raytracing. Può sembrare una banalità ma vi assicuriamo che non è così. Tradizionalmente, quando si parla di resa grafica nei videogiochi, ci si concentra essenzialmente sul processo di rasterizzazione, e cioè di trasformazione di una scena in 3D nell’immagine mostrata su schermo, passando attraverso diverse tappe: semplificando un po’ il processo, immaginate che dapprima si applicano dei calcoli geometrici per sapere come il giocatore vede un oggetto rispetto alla sua posizione (o quella di una camera), poi si riempiono i poligoni che lo compongono con delle texture e infine c’è un processo di illuminazione e di shading. Finora il punto debole in tutto questo è proprio l’illuminazione: prendendo un modello che corrisponde abbastanza bene alla realtà, potete immaginare che la luce è un raggio che parte da una sorgente e poi tocca oggetti, rimbalza, incontra altri raggi e così via.

Capite perfettamente che questo comporta una serie di operazioni complesse e interminabili, che possono certamente essere applicati per della grafica pre-calcolata, ma che rendono praticamente impossibile riprodurre la luce in tempo reale. Per questa ragione, gli sviluppatori hanno inventato nel tempo tutta una serie di trucchi e strategie per ingannare il giocatore, dando l’illusione di generare degli effetti di luce più o meno realistici. Un esempio classico per farvi capire come si sono trattate finora queste problematiche è quello di uno specchio in un videogame. I modelli 3D di personaggio, ambiente circostante, effetti speciali e via dicendo vengono trasformati in un’immagine piatta da applicare alla superfice dello specchio. Il risultato sarà una riflessione ma con limiti piuttosto importanti. Non è infatti praticabile creare una riflessione di una riflessione in tempo reale perché il calcolo andrebbe fatto due, tre, quattro, cento volte con un impatto enorme sulle prestazioni della pipeline grafica, a discapito di velocità e altre operazioni più importanti nell’ambito di un gioco. Immaginate ora che questo problema nasce praticamente ogni volta che dovete simulare un effetto legato alla luce! Ebbene, la prima grande sorpresa della tecnologia RTX è quello di riuscire a riprodurre in tempo reale una tecnica di illuminazione che copia piuttosto bene la realtà: il raytracing. Al posto di “barare” nell’illuminare gli ambienti di gioco con approssimazioni di vario tipo, il raytracing simula il comportamento di singoli raggi di luce. Nella tecnologia messa a punto da Nvidia i raggi di luce (diciamolo chiaramente, non ogni raggio di luce possibile immaginabile perché sarebbe proibitivo, ma una quantità sufficientemente importante) vengono emessi da una sorgente e interagiscono con ogni elemento del gioco in base a diversi parametri “fisici” quali tipo di materiale (metallo, legno, roccia, ecc.), tipo di superfice (opaca, lucida, traslucida, ecc.), illuminazione proveniente da altri oggetti e via dicendo. Ogni raggio sarà dunque riflesso ed influenzato dal primo materiale con cui interagisce e continuerà la sua corsa fino al prossimo materiale e via dicendo. Calcolando così ogni interazione luminosa con l’ambiente è possibile simulare in modo molto più accurato il comportamento di luci, ombre, riflessioni, ecc. e ottenere un risultato molto più vicino alla realtà. Per anni questa tecnologia è stata solo un sogno per quanto riguarda la grafica in tempo reale ed è rimasta appannaggio esclusivo dei grandi studi di computer animation, come ad esempio Pixar. Il motivo è molto semplice: il raytracing è un carico straordinariamente complesso che richiede una potenza di calcolo enorme.

Di raytracing e del suo impatto sui videogiochi abbiamo già parlato, timidamente, durante lo scorso E3 quando abbiamo visto per la prima volta dal vivo una DGX Station, un PC creato da Nvidia con 4 GPU Volta dal costo di circa 60’000 dollari. Un prezzo esorbitante che Nvidia, in un raro slancio di umorismo, ha deciso di prendere in giro durante la conferenza di Colonia. Ma tutto questo humor era finalizzato ad un comparativo molto interessante: stando a Jensen Huang una singola RTX 2080 Ti (dal prezzo di circa 1350 CHF) sarebbe in grado di rivaleggiare con una DGX Station dotata di quattro GPU Volta dal costo di 50 volte superiore. L’esempio portato durante la conferenza è la famosa demo Star Wars (che potete vedere nell’articolo dell’E3). Una DGX Station sarebbe in grado di produrre immagini in 55ms mentre una scheda basata su Turing lo farebbe in 45ms: un risultato eccezionale, specialmente perché una GPU GTX 1080 Ti lo farebbe in 308ms. Stando a Huang insomma Nvidia ha messo un supercomputer in un prodotto consumer in una singola generazione delle sue tecnologie. Ovviamente fare comparativi “Turing vs Pascal” non ha molto senso, visto che Turing è composta da hardware apposito per effettuare i calcoli necessari al raytracing che una GPU Pascal semplicemente non possiede e che deve emulare. Per questo motivo, Nvidia parla di un salto prestazionale enorme: Turing possiede capacità che Pascal semplicemente non ha e che possono essere considerate una rivoluzione nel mondo delle GPU.

Ecco perché Nvidia, in conferenza stampa, ha dovuto introdurre un indicatore speciale per quantità di raggi al secondo e di performances. Per RTX 2080 Ti si parla di 10 GigaRays/secondo e 78T RTX-OPS (non ci soffermiamo sui dettagli delle altre versioni di RTX, che trovate nella tabella qui sotto).

Ogni GPU è stata valutata in base a quanti raggi raytrace è in grado di gestire al secondo – GigaRays(sec) – e quante operazioni comprendenti elementi raytracing è in grado di calcolare (Tera RTX-OPS). Ovviamente è necessario specificare che queste cifre sono prodotte da Nvidia e quindi, come sempre in questi casi, da prendere con le pinze. Per cominciare la nozione di performance in tera RTX-OPS è calcolata come “operazioni matematiche equivalenti aggregate prodotte dai Turing shader, CUDA Core, Tensor Core e RT Core necessarie per il rendering della grafica RTX.” Insomma, una performance totale aggregata di ogni componente della GPU Turing in quello che, immaginiamo, sia un caso ideale. Come questa metrica si traduca nella realtà è tutto un altro paio di maniche e dipenderà da una marea di fattori, non da ultimo il tipo di implementazione del raytracing nei giochi che – non è nemmeno il caso di dirlo – varierà in modo sostanziale da gioco a gioco e da engine grafico ad engine grafico.

In effetti che questi numeri strabilianti non si traducano in guadagni stratosferici nei giochi attuali è stato più o meno dimostrato da testate indipendenti con Battlefield V e Shadow of the Tomb Raider i quali sarebbero stati renderizzati durante l’evento post conferenza in risoluzione Full HD e 60 FPS. Cosa significa per Nvidia RTX? Ora come ora, molto poco. I giochi non sono ottimizzati, i driver nemmeno. Sarà che siamo troppo cauti ma per ora, secondo noi, sbilanciarsi ha poco senso, anche perché Nvidia non è stata molto prolissa nel dare informazioni sull’impatto sulla pipeline in termini di programmazione. Sinceramente non capiamo cosa possano aver dimostrato queste testate. Stiamo parlando di luce, che finora non c’era (non così almeno). Al massimo si può dire che sì, la grafica fa un salto di qualità, ma che giocando si rischia di notare poco (o che ci si abitua veloce). Per vedere il vero impatto bisogna piuttosto pensare ai giochi futuri che utilizzeranno l’RTX nelle meccaniche. È la solita problematica di “foundational” e “decorational” techs, che vale per tutto ciò che è nuovo. Metro ha accennato all’utilizzo della luce per nascondere i nemici: lì, l’impatto sull’esperienza sarà reale, con una differenza non solo visiva ma anche di gameplay che non è semplicemente possibile con una GPU attuale.

Deep learning super sampling!

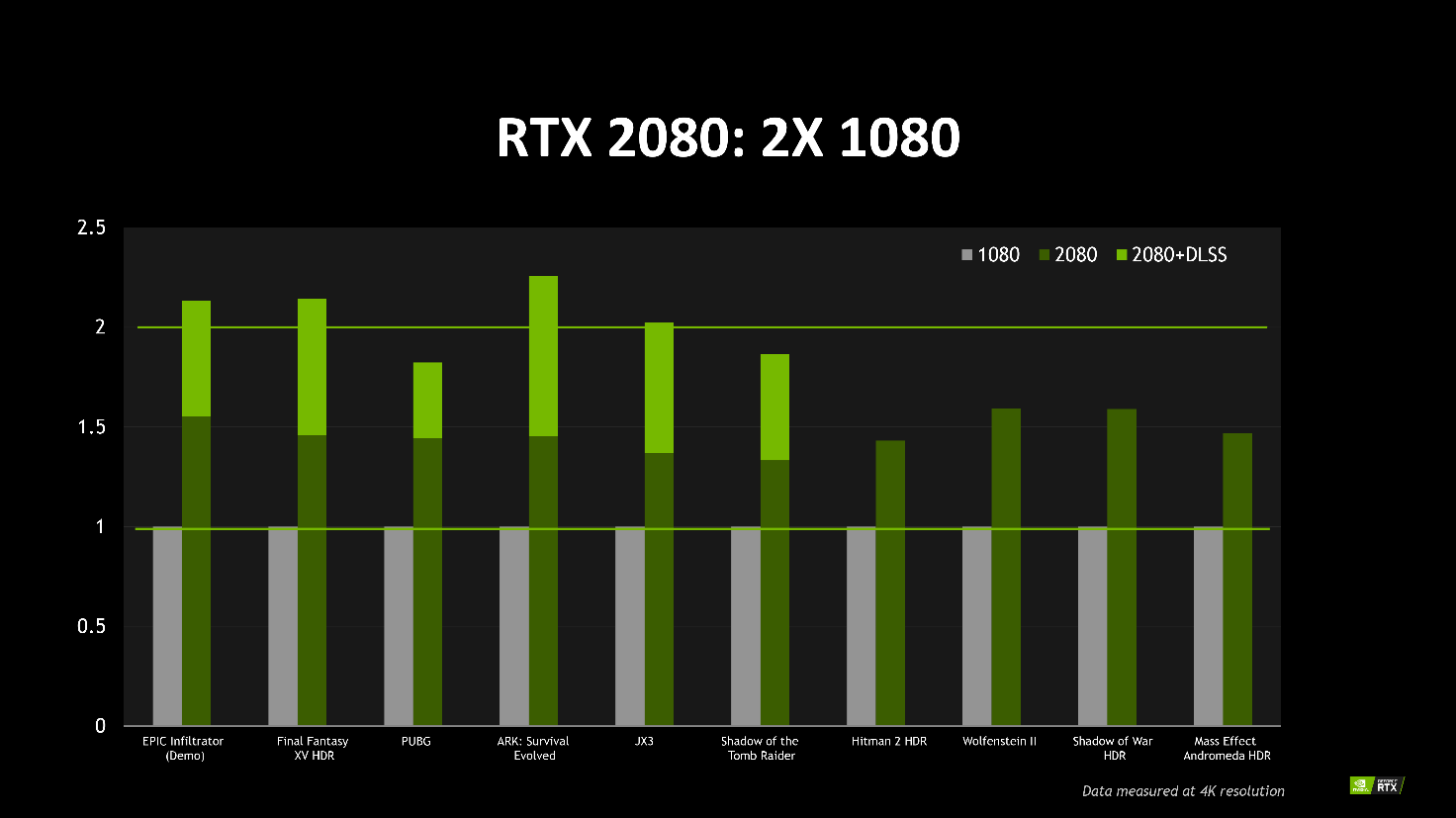

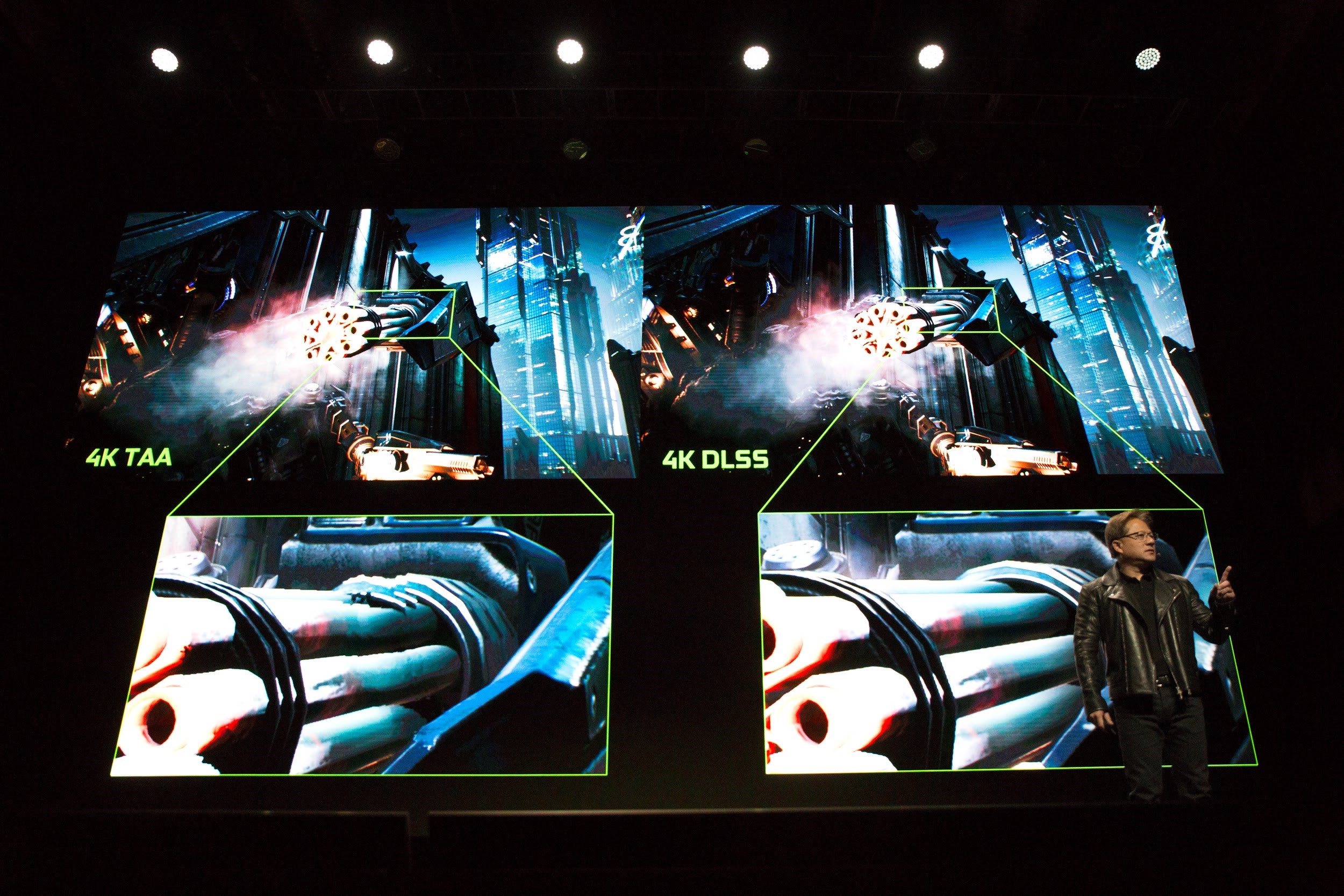

Una delle componenti principali del chip Touring è la parte dedicata all’intelligenza artificiale, che trae beneficio dal deep learning. Con questa tecnica, molto in voga in questo momento, si cerca di insegnare un compito a un computer, dandogli in pasto tantissimi esempi da elaborare perché “capisca” come agire. I campi di utilizzo sono un’infinità e Nvidia ha immaginato un nuovo modo per creare un’immagine più dettagliata e precisa usando l’intelligenza artificiale e i Tensor core presenti sulle RTX. In pratica il DLSS serve a ricreare informazioni grafiche dove queste non esistono, disattivando al contempo l’anti-alias che, come sappiamo, ha un impatto sulle prestazioni finali e fa perdere nitidezza ai contorni degli oggetti. Per beneficiare del DLSS però, nvidia deve dapprima “addestrare” il sistema di deep learning perché riesca a ricreare queste informazioni mancanti. Quello che viene imparato può così essere salvato in uno o forse più profili, che l’utente potrà scaricare e usare sulla propria macchina, verosimilmente tramite un sistema come GeForce Experience. In più, a differenza dell’antialias che può essere semplicemente imposto dai driver, ogni gioco dovrà supportare DLSS e la lista per ora comprende 16 titoli tra cui Shadow of the Tomb Raider, PUBG, FF XV e Hitman 2.

Tiriamo le somme

Le nuove GPU RTX di Nvidia faranno discutere ancora a lungo. Da un lato si tratta di hardware che, sulla carta, sembra essere estremamente potente e che per certo segna una nuova tappa nella storia delle GPU. Dall’altro lato però ci sono ancora parecchi punti su cui bisognerà fare luce in modo indipendente. La metrica usata da Nvidia è, per loro stessa ammissione, un’invenzione dovuta all’introduzione di sistemi di render ibridi che miscelano le tradizionali tecniche di rasterizzazione al raytracing, per il semplice motivo che contare solo sul secondo rimane tuttora impossibile. Stando a Nvidia “l’invenzione della grafica ibrida richiede un nuovo modo di misurare le prestazioni che chiamiamo RTX-OPS, ovvero le prestazioni disponibili quando si rendono giochi di nuova generazione con grafica ibrida.” Un po’ fumoso per quanto riguarda gli FPS finali di un gioco (ammesso che vogliamo basarci solo su quello come indicatore di performances – il che ci sembra una buona approssimazione). Staremo a vedere cosa succederà nei mesi a venire e come gli sviluppatori introdurranno le capacità delle RTX nei propri giochi.

A questo articolo ha collaborato Mauri.