Raramente una recensione ha avuto una genesi tanto complessa come quella che state leggendo. Quando si parla di tecnologia cutting edge, spesso e volentieri ci imbattiamo in qualche problemino di gioventù, qualche incompatibilità o comunque qualche grattacapo.

La recensione della RTX 3090 Strix di Asus è stato un viaggio che ha fatto tappa perfino con una RTX 3080 TUF, sempre di Asus. Ma finalmente ci siamo e, come spesso accade, un viaggio turbolento è più interessante da raccontare. Diamo un’occhiata alla flagship di Asus!

Potenza massima

Ora come ora non c’è granché in grado di battere questa RTX 3090 (più precisamente il modello ROG-STRIX-RTX3090-O24G-GAMING). Caratterizzata da una potenza inaudita, un costo proibitivo e supporto ad ogni moderna tecnologia immaginabile, si tratta della GPU ultima (per il 2020, è chiaro). Basata sull’ultimo chip grafico di Nvidia, questa scheda di Asus offre collegamento PCI-E 4.0 e ben 24GB di GDDR6X. La GPU è composta da 10496 CUDA core. La GPU GA102-300-A1 su cui si basa questa 3090 è dotata di 10,496 processori shader e 28 miliardi di transistor. La memoria ha un’interfaccia a 384 bit per una velocità massima di circa 19.5Gbps. Cifre e specifiche che sulla carta possono dire molto o tanto, quindi passiamo a qualcosa di più comprensibile. RTX 3090 supporta risoluzioni fino a 8K (7680×4320) grazie alla porta HDMI 2.1 nativa inclusa, oltre a DisplayPort 1.4a. In effetti è possibile collegare fino a quattro monitor in contemporanea tramite usando 4 delle 5 porte video (2 HDMI e 3 DisplayPort) messe a disposizione dal design di Asus. RTX 3090 è l’unica scheda della nuova generazione ad offrire ancora la possibilità di sfruttare lo SLI, tramite un collegamento NVlink anche se oramai si può considerare questa tecnologia come defunta, visto che la stessa Nvidia ha annunciato che non pubblicherà più profili SLI per i giochi (e comunque due 3090 in SLI costano come due computer da gaming interi, quindi ben poca gente se ne doterà).

La scheda in sé è un mostro: 31.85 x 14.01 x 5.78 centimetri di dimensioni, 1565 grammi di peso e ben tre connettori di alimentazione a 8-pin (Asus raccomanda almeno 850W di alimentatore, noi andremmo piuttosto sopra i 1000W per stare tranquilli visto che questo modello può richiedere fino a 480W da sola, ben al di sopra dei 350W del design di referenza di Nvidia). Sono fattori che vanno tenuti assolutamente in considerazione durante la pianificazione di qualsiasi build: una scheda da tre slot come questa, con la necessità di dissipare una marea di calore e con ben tre cavi di alimentazione non si prestano certo ad essere usata in un case Mini-ITX, anche se la fantasia di modder e builder è sempre fonte d’ispirazione. Questa scheda è dotata di un design dual-bios con modalità prestazioni e silenziosa. In quest’ultima, i tre fan iniziano a girare solo dopo un certo limite, restando fermi (e assolutamente silenziosi di conseguenza) quando non è necessario.

Generalmente il design di Asus è piacevole, la scheda è dotata di illuminazione RGB ma non è assurdamente pacchiana come altri prodotti (anche di Asus eh!) visti in passato, peccato forse per l’enorme scritta “GEFORCE RTX” che peraltro non riporta il numero 3090; se vogliamo figheggiare almeno datemi anche il modello, per assicuraci dominazione sugli altri! Lo shroud esterno è nero e grigio e copre il massiccio radiatore ad aria che si occupa di raffreddare GPU, RAM e altri componenti sul PCB. Le tre ventole sono non girano tutte nello stesso senso ma sono alternate, in questo modo l’efficienza di raffreddamento dovrebbe essere migliore (anche se, volendo, possiamo optare per un blocco per il raffreddamento a liquido).

Una lunga battaglia

L’installazione fisica è semplice, se abbiamo un case con sufficiente spazio: inseriamo nello slot PCI-E 4.0 (o anche 3.0), colleghiamo i 3 cavi da 8-pin per l’alimentazione e siamo pronti. Almeno, questo in un mondo perfetto. In realtà abbiamo avuto tantissimi problemi sia con 3090 che 3080 ed è stato un viaggio di scoperta che vale la pena di raccontare, per evitarvi problemi. Come detto, dovevamo inizialmente recensire anche una 3080 TUF ma abbiamo dovuto desistere. Infiniti crash del driver video, di Windows, dei giochi,… Abbiamo provato ogni trucco del mestiere: cambiare driver, disinstallazione completa, reinstallazione di Windows 10, aggiornamenti, BIOS update, altro PSU, sacrifici di piccoli animali di pezza. Convinti che fosse un problema di una GPU difettosa, l’abbiamo restituita ad Asus.

A sinistra una TUF 3080 in pieno troubleshooting, a destra la 3090 funzionante

Avanti veloce di qualche settimana, arrivata la 3090 abbiamo avuto lo stesso identico problema: crash, driver error 43, reset del driver video a non finire. Per tagliare la testa al toro siamo passati da un PSU da 850W a uno da 1200W (sempre meglio abbondare, anche in un’ottica di efficienza) senza però risolvere il problema. Dopo tante (TANTE!) ore di troubleshooting è saltato fuori che si tratta di un bug (?) della nostra scheda madre, una Asus ROG Crosshair VIII Formula. In pratica, la Bios permette di selezionare quale generazione PCI-E supportare e normalmente è impostata su Auto (in modo da passare da PCI-E 3.0 a 4.0 da sola). Il problema è che se usiamo la GPU in modalità Auto (ovvero 4.0) avremo le instabilità di cui abbiamo parlato. È bastato impostare la compatibilità su PCI-E 3.0 per risolvere magicamente ogni problema. Ora, non abbiamo notizie ufficiali da parte del costruttore riguardo a questo potenziale bug (presente fino alla versione 2311 del Bios). Si tratta comunque di una cosa da sapere che potrebbe risparmiarvi una carrettata di grattacapi. Peccato per la 3080, perché non aveva niente di sbagliato…

Giocare in 8K

Una delle promesse più roboanti di Nvidia è sicuramente quella che una 3090 permette di giocare in 8K con titoli attuali e con raytracking attivo. Una cosa assai difficile da provare per moltissimi tra noi, visto che quasi nessuno possiede uno schermo in grado di supportare l’8K. Beh, noi tale schermo ce l’abbiamo e ci abbiamo provato! Per prima cosa, bisogna assicurarsi che ogni device supporti la specifica HDMI 2.1. Nel nostro caso, RTX 3090 è dotata di tale collegamento e la nostra TV (la Samsung Q900R) è stata aggiornata per supportare tale tecnologia su una porta HDMI delle quattro proposte. Resta solo il cavo: serve un cavo certificato 8K, non potrete recuperare un vecchio cavo HDMI da un cassetto e sperare di farcela. Una volta collegato tutto come si deve, Windows 10 ha magicamente (e con nostra enorme sorpresa) impostato la risoluzione nativa della TV, 7680×4320 a 60Hz con HDR attivo (422 ovviamente). Va anche detto che però ogni tanto abbiamo avuto problemi, con la TV che mostra un segnale distorto, completamente incomprensibile o altri artefatti. Tendiamo a dare però la colpa alla TV piuttosto che alla GPU, visto che abbiamo avuto qualche incertezza anche con PS5 e Xbox Series X di recente.

RTX2080Ti vs RTX3090

Il primo impatto con l’8K è spettacolare. Se riuscite a trovare contenuti fatti per tale risoluzione. YouTube è un buon luogo da cui iniziare, visto che ci sono diversi contenuti in 8K HDR. Per assicurarci la migliore performance possibile abbiamo scaricato alcuni file. Con nostra enorme sorpresa, alcuni file sono risultati inguardabili. Specialmente un certo filmato: Morocco 8K HDR 60FPS (FUHD). In locale abbiamo visto un uso della GPU ad oltre il 90% e la CPU (un Ryzen 9 3900X!) ad oltre il 50% senza per altro avere un video fluido (anzi, si blocca dopo qualche secondo). L’8K è una bestia selvaggia che abbiamo appena iniziato a conoscere, tra il codec AV1 per i video (rispetto a VP9) e la potenza necessaria per decodificarlo. Quando funziona però è spettacolare. Vi proponiamo un esperimento empirico un po’ sciocco ma che illustra bene la situazione. La foto a sinistra qua sotto è stata fatta alla TV con un video 8K in riproduzione con un Galaxy S10+. A sinistra, la stessa immagine ma fotografata più da lontano. Abbiamo provato a mandare la foto di sinistra in giro e nessuno si è accorto che si trattava di una foto fatta ad uno schermo. L’8K è davvero nitido!

Ma passiamo ai giochi! In realtà, il supporto è un po’ hit or miss. Alcuni giochi accettano di buon grado l’8K, altri necessitano di essere giocati in finestra senza bordi. Il cambio di risoluzione repentino manda in confusione la nostra TV. Ma abbiamo fatto dei benchmark con Watch Dogs Legion con due risoluzioni diverse: 8K e 3840×1080. Una tavola comparativa ci permette di dare un’occhiata all’impatto di risoluzione, DLSS e raytracing.

| Risoluzione | DLSS | Raytracing | Preset | FPS minimi | FPS Medi | FPS massimi | 1% FPS bassi |

| 7680×4320 | Prestazioni ultra | No | Ultra | 29.83 | 52.97 | 78.41 | 43.53 |

| 7680×4320 | Prestazioni ultra | Ultra | Ultra | 23.89 | 37.65 | 67.51 | 31.31 |

| 7680×4320 | No | No | Ultra | 11.03 | 20.24 | 26.64 | 16.80 |

| 7680×4320 | No | Ultra | Ultra | 7.25 | 10.04 | 13.89 | 8.26 |

| 7680×4320 | Bilanciato | Ultra | Ultra | 14.68 | 22.06 | 33.23 | 18.32 |

| 3840×1080 | Bilanciato | Ultra | Ultra | 40.99 | 66.13 | 105.83 | 46.64 |

| 3840×1080 | No | Ultra | Ultra | 23.96 | 47.54 | 99.11 | 36.62 |

Quello che salta all’occhio è che giocare in 8K nativi è impossibile, specialmente se spingiamo ogni altro dettaglio al massimo (raytracing compreso). Nvidia parlava di Control riguardo all’8K ma lo stesso discorso vale anche qua: o usiamo DLSS (deep learning super sample) oppure avremo performances nell’ordine di 10-15 FPS, sicuramente non frame rates giocabili. Tuttavia, DLSS ha un non so ché di magico perché attivarlo riporta le performances in zone assolutamente giocabili. Legion in 8K con DLSS sul nostro PC è più fluido dell’esperienza regolare di una Xbox One X o PlayStation 4 Pro. Impressionante. Ad ogni buon conto ad 8K vediamo come il raytracing abbia un impatto meno significativo di quanto potremmo aspettarci rispetto delle varie impostazioni di DLSS, è l’impressionante quantitativo di pixel a fare la differenza in questo caso. Dovendo scegliere una impostazione per giocare diremmo 8K con DLSS su prestazioni ultra e una impostazione raytracing media per ottenere con una certa consistenza 30 FPS.

Messa alla prova

Ovviamente un solo gioco non basta a definire le potenzialità di questa GPU, sebbene ci dia una chiara indicazione. Abbiamo quindi fatto una batteria di test, sintetici e non, per mettere le cose in chiaro. Iniziamo con i test di 3DMark, che ci permettono non solo di testare performances in raytracing ma anche di comparare questa scheda con la 2080Ti e altre GPU ancora. In più abbiamo qualche dato che siamo riusciti a racimolare, in extremis, con la 3080 TUF. Iniziamo dal buon vecchio 3DMark e compariamo i risultati tra 2080Ti, 3080 (dove siamo riusciti a testare) e 3090.

| GPU | 2080Ti | 3080 | 3090 |

| TimeSpy | 12243 | 16942 | 18288 |

| TimeSpy Extreme | 6634 | – | 9499 |

| PortRoyal | 8527 | 11504 | 12040 |

La progressione tra questi risultati è esattamente in linea con le aspettative e vediamo la progressione tra 2080Ti, 3080 e 3090 sebbene sia interessante notare come tra le nuove RTX3000 la differenza non sia poi così abissale, a differenza del prezzo di vendita tra i due modelli.

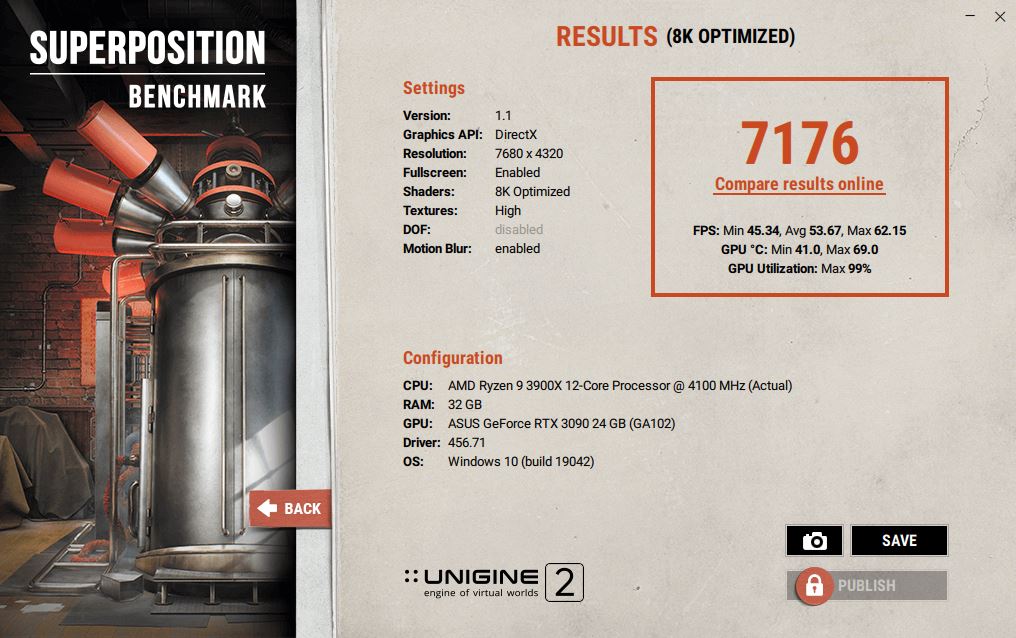

Abbiamo anche testato, come nostro solito, Unigine Superposition, ottenendo praticamente lo stesso tipo di risultato. Le due GPU sono assai performanti ma, come previsto, 3090 ottiene risultati migliori anche se non di moltissimo, segno che probabilmente il collo di bottiglia sta da qualche altra parte.

| GPU | 3080 | 3090 |

| 8K Optimized | 6481 | 7176 |

| 4K Optimized | 14880 | 15936 |

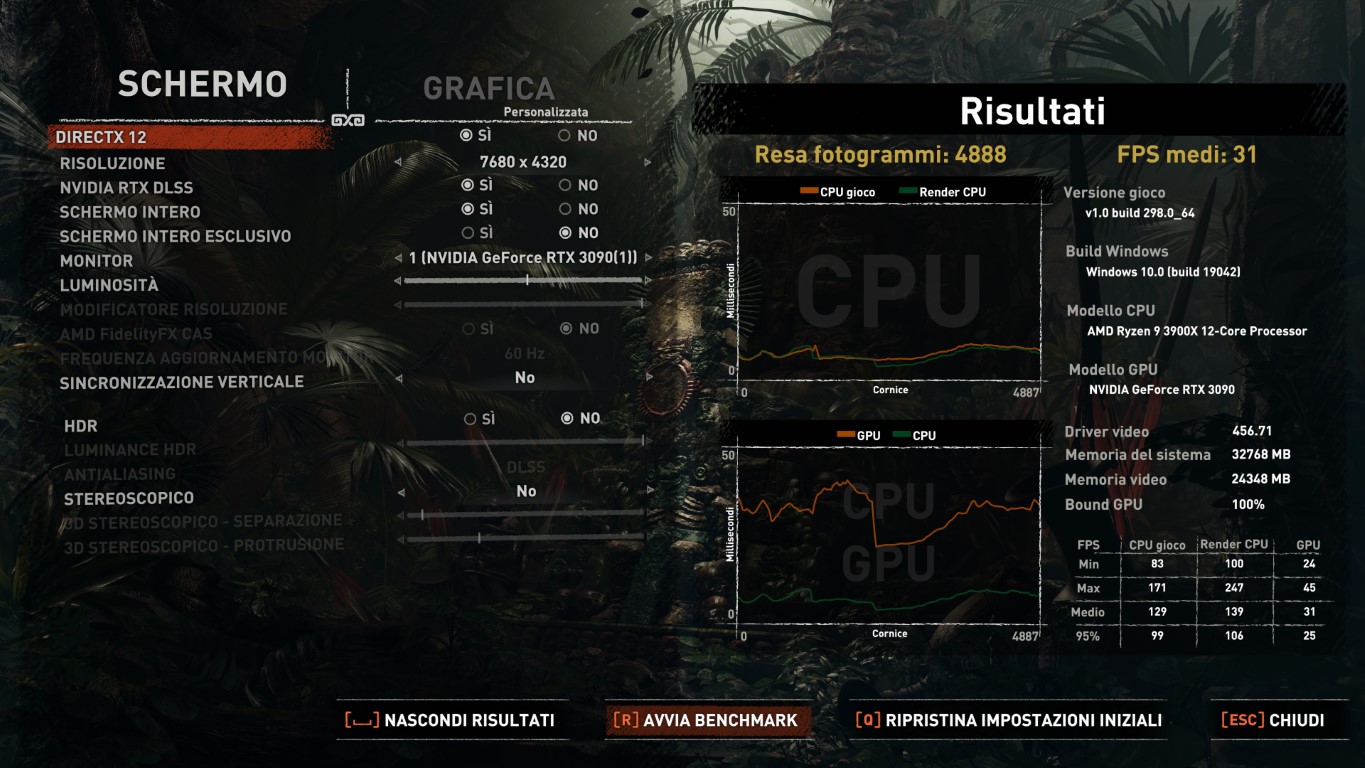

Passiamo allora a qualche gioco oltre al già citato Watch Dogs Legion. Abbiamo fatto qualche test con Shadow of the Tomb Raider, gioco che supporta anche raytracing e offre un interessante tool di benchmark. Alla nostra risoluzione farlocca di 3840×1080 il gioco ottiene di media 92 FPS che diventano 31 in risoluzione 8K (ma con DLSS attivo, ovviamente). Anche in questo caso, RTX3090 si conferma essere una GPU potente a sufficienza per giocare a tali risoluzioni ridicole con un grado di performances comparabili ad una console old gen.

Shadow of the Tomb Raider in 8K

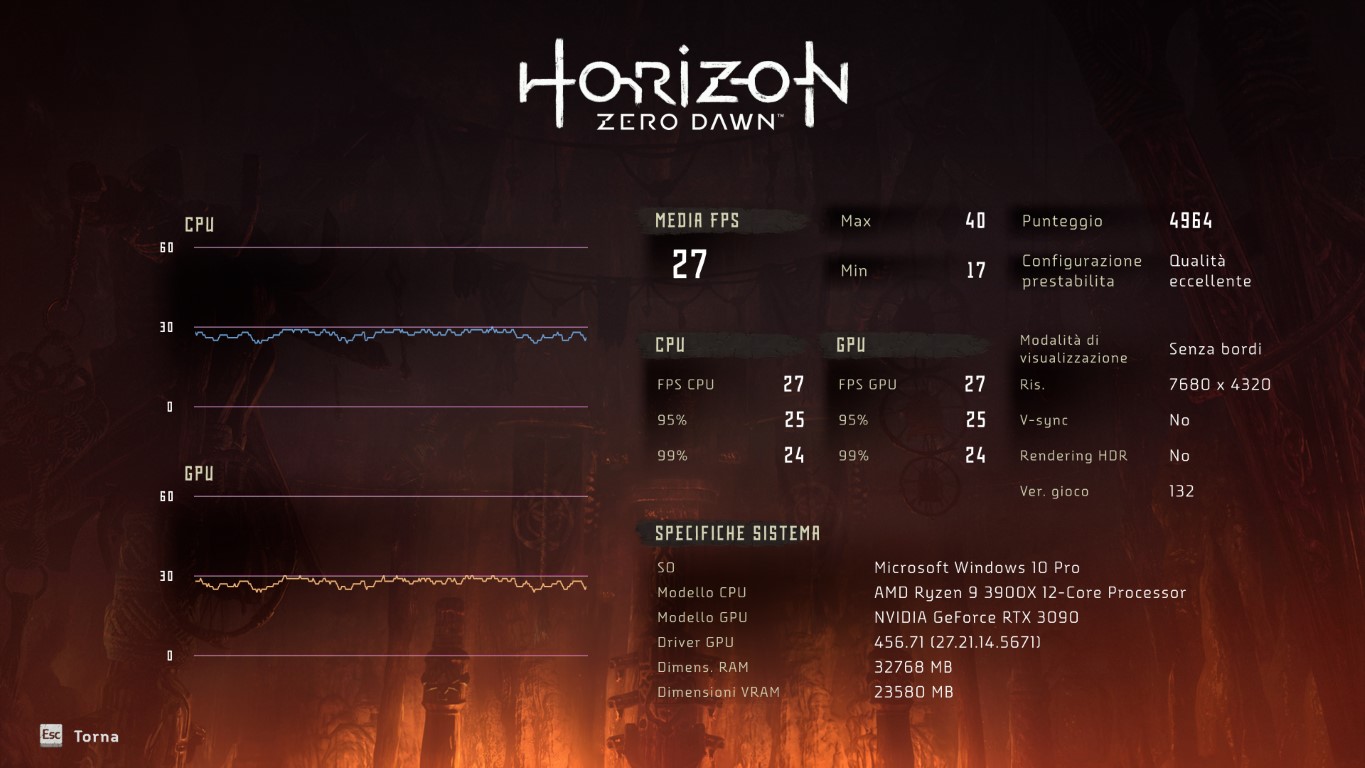

Un altro titolo testato è Horizon Zero Dawn, sia in 3840×1080, ottenendo 105 FPS di media con dettagli “qualità eccellente” che 27 FPS di media, sempre in “qualità eccellente” ma in 8K senza DLSS. Un risultato che ci ha abbastanza sorpreso, in positivo.

Horizon Zero Dawn in 8K

Per finire, Doom Eternal che tocca picchi fino a 320 FPS (la media è più sui 280 FPS) in dettagli ultra nightmare a 3840×1080 e Destiny 2, sulla Terra, ottiene una media dignitosa di circa 100 FPS. Sfortunatamente non siamo mai riusciti ad arrivare sin qua con la 3080. Insomma, quale che sia il gioco al quale giocherete, se avete un sistema in grado di sfamare una RTX3090, otterrete performances stellari.

Conclusione

Questa RTX 3090 Strix di Asus è un mostro di potenza. Ma non solo, anche la costruzione ci è parsa davvero ottima, senza il benché minimo coil whine sotto sforzo (rispetto alla nostra 2080Ti di Zotac, chiaramente udibile). Certo, a 1869 CHF (su Digitec, al momento della pubblicazione di questa review) dobbiamo chiederci se è un investimento sensato. Beh, la risposta è semplicissima: non lo è. Pagare quasi 2000CHF per una GPU è ridicolo, stupido e insensato. E c’è gente che lo farà lo stesso! Perché da un lato questa 3090 è, attualmente, la GPU che rimpiazza la linea Titan. Dall’altro perché se vogliamo performances ridicolmente fuori dal comune, il prezzo passa in secondo piano. RTX3090 è la GPU eccessiva che, come una Pagani Zonda, non serve davvero ma questo non ci impedisce di desiderarne una e, se possiamo permettercelo, di comprarne una. Nessuno fa mistero di questa cosa tra l’altro. Per giocare in 4K una RTX3080 costa un’infinità in meno e offre performances assolutamente degne di nota.

Se ci accontentiamo di 1440p possiamo anche fermarci ad una 3070. Entrambe le schede, tra l’altro, hanno prezzi assai più competitivi della serie 2000 al lancio. RTX3090 è allora la GPU Nvidia definita per il 2020. Con 24GB di RAM potremo usarla anche in render e modeling professionali, in cui è la RAM a definire i limiti di certe applicazioni e in cui i “miseri” 10GB di RTX3080 sono un limite. Se siete un gamer e basta, questa GPU è semplicemente troppo overkill. Asus ha fatto i compitini alla grande, offrendo una GPU già oveclockata di fabbrica e in grado di sopportare anche qualcosina in più. Ma il prezzo (oddio il prezzo!), la necessità dei tre cavi di alimentazione e la quantità allucinante di calore emesso da questa GPU sotto stress sono fattori da tenere in considerazione. Per il prezzo c’è poco da fare, o potete permettervela o non potete. I tre cavi, beh possiamo viverci assieme se pianifichiamo la nostra build con attenzione. Per il calore, è imperativo usare un open case oppure un case con un ottimo airflow, per evitare di cuocere non solo la scheda video ma anche tutto il resto del sistema. Se questi limiti per voi non sono un problema, beh, si tratta della scheda Ultra HD da avere nel 2020 (e probabilmente anche per un paio d’anni a venire).

The Good

- Potenza inaudita

- 8K

- Design, performances termiche e zero coil whine

The Bad

- Prezzo allucinante

- Necessita ottimo airflow

- Dimensioni fisiche